Apr.18 2023

产业洞察

AI服务器出货动能强劲带动HBM(high bandwidth memory)需求提升,据TrendForce集邦咨询研究显示,2022年三大原厂HBM市占率分别为SK海力士(SK hynix)50%、三星(Samsung)约40%、美光(Micron)约10%。此外,高阶深度学习AI GPU的规格也刺激HBM产品更迭,2023下半年伴随NVIDIA H100与AMD MI300的搭载,三大原厂也已规划相对应规格HBM3的量产。因此,在今年将有更多客户导入HBM3的预期下,SK海力士作为目前唯一量产新世代HBM3产品的供应商,其整体HBM市占率可望藉此提升至53%,而三星、美光则预计陆续在今年底至明年初量产,HBM市占率分别为38%及9%。

预估2023年AI服务器出货量年增15.4%

目前NVIDIA所定义的DL/ ML型AI服务器平均每台均搭载4张或8张高端显卡,搭配两颗主流型号的x86 服务器CPU,而主要拉货力道来自于美系云端业者Google、AWS、Meta与Microsoft。据TrendForce集邦咨询统计,2022年高端搭载GPGPU的服务器出货量年增约9%,其中近80%的出货量均集中在中、美系八大云端业者。展望2023年,Microsoft、Meta、Baidu与ByteDance相继推出基于生成式AI衍生的产品服务而积极加单,预估今年AI服务器出货量年增率可望达15.4%,2023~2027年AI 服务器出货量年复合成长率约12.2%。

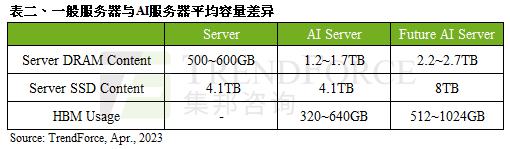

AI服务器刺激Server DRAM、SSD与HBM需求同步上升

根据TrendForce集邦咨询调查,AI服务器可望带动存储器需求成长,以现阶段而言, Server DRAM普遍配置约为500~600GB左右,而AI服务器在单条模组上则多采64~128GB,平均容量可达1.2~1.7TB之间。以Enterprise SSD而言,由于AI服务器追求的速度更高,其要求优先满足DRAM或HBM需求,在SSD的容量提升上则呈现非必要扩大容量的态势,但在传输接口上,则会为了高速运算的需求而优先采用PCIe 5.0。而相较于一般服务器而言,AI服务器多增加GPGPU的使用,因此以NVIDIA A100 80GB配置4或8张计算,HBM用量约为320~640GB。未来在AI模型逐渐复杂化的趋势下,将刺激更多的存储器用量,并同步带动Server DRAM、SSD以及HBM的需求成长。

PS:当您需要在报道中引用TrendForce集邦咨询提供的研报内容或分析资料,请注明资料来源为TrendForce集邦咨询。

近期文章精选 TrendForce

TrendForce集邦咨询是一家横跨存储、集成电路与半导体、晶圆代工、光电显示、LED、新能源、智能终端、5G与通讯网络、汽车电子和人工智能等领域的全球高科技产业研究机构。公司在行业研究、政府产业发展规划、项目评估与可行性分析、企业咨询与战略规划、品牌营销等方面积累了多年的丰富经验,是政企客户在高科技领域进行产业分析、规划评估、顾问咨询、品牌宣传的优质合作伙伴。

TrendForce is a global high-tech industry research institution. Its research scope covers memory, IC and semiconductors, foundry, optoelectronic display, LED, new energy, smart terminals, 5G and communication networks, automotive electronics, as well as AI. With rich experience in industry research, government industry development planning, project feasibility analysis, corporate consulting and brand marketing, TrendForce is a quality partner for government and enterprise clients to conduct industrial analysis, planning evaluation, consulting and brand promotion in high-tech field.

△ 向上滑动查看